Es klingt eigentlich wie das einfachste Rezept der Welt. Um Knoblauchöl herzustellen, nimmt man einfach einige leicht angedrückte Knoblauchzehen und gibt sie in das Öl. Doch genau dieser Vorgang kann zu möglicherweise tödlichem Bakterienwachstum führen.

Auf Reddit soll Googles Chatbot Gemini genau zu diesem Vorgehen geraten haben, ohne die Risiken zu erwähnen. Ein Nutzer postete einen Chat mit Gemini, in dem er nach dem richtigen Vorgehen fragt, wenn er Knoblauch in Öl einlegen möchte.

Die KI gab auch denkbar einfache Anweisungen: Knoblauch schälen, ein bisschen andrücken und in ein sauberes Glas geben. Olivenöl drüberkippen, bis der Knoblauch völlig bedeckt ist. Abschließend soll das Gefäß verschlossen werden, und die Knoblauchzehen dürfen bei Zimmertemperatur eine Woche lang ziehen.

Bakterienwachstum gefördert

Zunächst schien alles nach Plan zu verlaufen, heißt es in dem Reddit-Posting. Der Benutzer bemerkte jedoch nach einigen Tagen, wie kleine Bläschen aufstiegen. Er hielt das jedoch für normal. Am siebenten Tag waren die Bläschen schließlich verschwunden. Dennoch gingen dem Ersteller des Postings die Bläschen nicht aus dem Kopf und er bemühte die traditionelle Google-Suche. Das eher unschöne Resultat: Entstehen derartige Bläschen, deutet das auf das Wachstum des Bakteriums Clostridium botulinum hin. Die dadurch verursachte Vergiftung wird Botulismus genannt. Die von diesem Bakterium gebildeten Nervengifte zählen zu den stärksten bekannten Giften und werden unter speziellen Umständen wie Sauerstoffabschluss gebildet.

Typisch sind Krankheitszeichen etwa zwölf bis 36 Stunden nach Verzehr von betroffenen Lebensmitteln. Es können Sehstörungen, Schluckstörungen sowie eine schnell fortschreitende schlaffe Lähmung auftreten. Patienten mit diesen Symptomen gehören umgehend in ärztliche Behandlung, warnt etwa das Gesundheitsministerium.

Das Bakterium dürfte in diesem Fall besonders gut gediehen sein, weil bei Ölinfusionen üblicherweise anaerobe Bedingungen herrschen, wie Golem berichtet. In Österreich sind derartige Vorfälle aber extrem selten: Seit dem Jahr 2000 wurden bundesweit 20 Fälle gemeldet.

Googles Problem mit KI-Aussagen

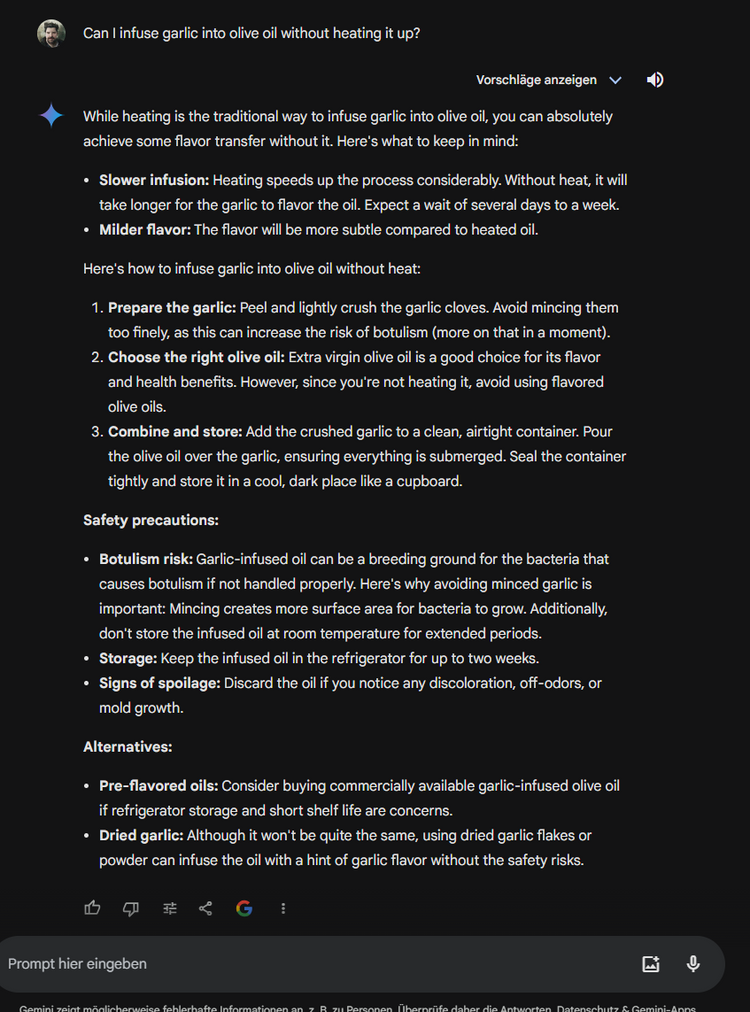

Der Fall zeigt aber auch, dass blindes Vertrauen in Ratschläge von Chatbots keine gute Idee ist und man das, was die Künstliche Intelligenz als Fakt präsentiert, immer überprüfen sollte. Fairerweise muss man im Fall von Gemini aber dazusagen, dass der Chatbot im Versuch des STANDARD mit dem exakt gleichlautenden Prompt sehr wohl auf die Gefahren der Bakterienbildung hinwies. Gemini riet sogar dazu, zu Fertigprodukten zu greifen, da es hier weniger Bedenken gibt.

Andererseits musste Google zuletzt immer wieder bei eigenen KI-Anwendungen nachbessern. Zuletzt waren es die "AI Overviews" in der Google-Suche, die für einige aus Google-Sicht höchst unangenehme Schlagzeilen sorgten. Das System fiel immer wieder mit seltsamen und irreführenden Antworten auf. So wurde etwa geraten, mindestens einmal täglich einen kleinen Stein zu verzehren – wegen des Mineralhaushalts im Körper. Und wenn der Käse dauernd von der Pizza rutscht, könnte man ihn ja mit ungiftigem Klebstoff ankleben, riet die KI.

Google reagierte und reduzierte die Zahl der "AI Overviews" und verbot gewisse Antworten quasi "per Hand". Das Problem: Plötzlich war der Kleber-Ratschlag wieder da. Ausgerechnet jene Berichte über das Versagen der "AI Overviews" waren es nämlich, die den falschen Tipp wieder ganz oben als Antwort auf die Frage "how much glue to add to pizza" katapultierten. Mittlerweile ist eine derartige Fragestellung nicht mehr möglich.

Fälschungen in Umlauf

Gleichzeitig kursierten aber auch viele Screenshots mit gefälschten Aussagen in den KI-Overviews. So ging etwa ein Posting viral, in dem "AI Overview" dazu riet, den Hund im heißen Auto zu lassen. Als Quelle wurde ein nicht existenter Beatles-Song genannt. Eine Fälschung, wie sich später herausstellte.

Insofern ist es auch schwierig nachzuprüfen, ob das Botulismus-Rezept tatsächlich echt ist oder ob Google nachgebessert und den Hinweis auf Bakterienwachstum nachträglich eingefügt hat. (red, 20.6.2024)