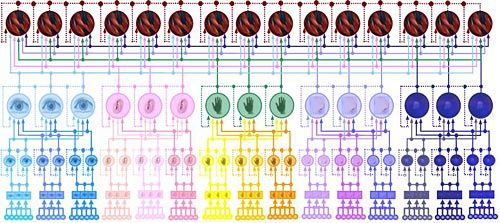

Struktur eines Neuro-Symbolischen Netzwerks.

Das System, das die frisch gebackene Sub auspiciis-Promovendin im Rahmen ihrer Dissertation am Institut für Computertechnik der TU Wien entwickelt hat, läuft bereits als Software, gleichsam als Simulation. Nun möchte Velik die Sache auch in entsprechende Hardware umsetzen.

"Heute funktioniert die Wahrnehmung durch Maschinen hauptsächlich als technische Lösungen mittels mathematischer Algorithmen, der Computer lernt über den Vergleich mit gespeicherten Daten", erklärte die Wissenschafterin. Die Ergebnisse sind dabei bekanntlich nicht immer überzeugend, häufig kommt es auch zu einer ausufernden Datenflut.

Wahrnehmung auf drei Ebenen

Velik hat im Laufe ihres Studiums der Elektrotechnik auch immer wieder Ausflüge ins Reich der Neurowissenschaften unternommen und dabei die Vorgänge im menschlichen Gehirn während der Wahrnehmung analysiert. "Im Prinzip läuft diese Wahrnehmung auf drei Ebenen ab", so die Forscherin. Auf der ersten Ebene nehmen die verschiedenen Sensoren, Augen, Ohren, Tastsinn etc., einfache Merkmale wahr. Im Falle des Auges wären dies beispielsweise Farben, Linien oder Kanten.

In einem zweiten Schritt werden diese Informationen zusammengefügt, es kommt zu einer Abstrahierung durch die Erkennung von Symbolen. Wird ein solches Symbol erkannt, beispielsweise "Gesicht" oder "Person", kann das System jene Wahrnehmung reduzieren, welche für die Erkennung dieses Symbols wichtig waren. Die Sensorik - in dem Fall die Augen - braucht sich nicht mehr auf Umrisse, Lage von Augen oder Ohren zu konzentrieren, es wird Kapazität etwa für die Wahrnehmung der Mimik frei. Auf einer dritten Ebene werden dann die Ergebnisse der verschiedenen Sensoren zusammengefügt, beispielsweise liefern Augen und Ohren die Information "Person spricht".

Realer Einsatz in Vorbereitung

Genau nach diesem Vorbild hat die Wissenschafterin nun ein erstes Modell zur maschinellen Wahrnehmung entwickelt. "Das System hat verschiedene Situationen erkannt, beispielsweise wenn eine Person den Raum betritt oder ihn wieder verlässt", berichtete Velik. Nun möchte sie das Programm mit der entsprechenden Hardware, etwa Kameras und Mikrofonen kombinieren und den Einsatz in der realen Welt vorbereiten.