Facebooks Algorithmen sind noch nicht ausgereift genug, um die Content-Moderation zu übernehmen.

Der Mensch ist eine Bestie. Diesen Eindruck gewinnt zumindest, wer sich Polizeiberichte, Gerichtsprotokolle und Meldungen aus Kriegsgebieten durchliest. Das spiegelt sich natürlich auch im Internet wider. "Vergewaltigungen, Sex mit Tieren, Sex mit Kindern, Verstümmelungen, Enthauptungen, Kotze, Scheiße und Pisse, die auch mal getrunken oder gegessen werden": So fasst der Regisseur Moritz Riesewieck jene Bilder und Videos zusammen, die täglich auf Facebook und anderen Plattformen kursieren – und auf den Bildschirmen junger Arbeiter in den Philippinen landen.

Hartnäckige Recherche

Dort hat sich eine ganze Branche an sogenannten "Commercial Content Moderators" herausgebildet, die im Auftrag von großen IT-Konzernen für vermeintliche "Sauberkeit" auf deren Plattformen sorgen sollen. Sie unterschreiben Verschwiegenheitsklauseln, über ihre Erlebnisse und Arbeitsvorgaben dringt normalerweise nichts nach außen. Riesewieck ist allerdings auf die Philippinen gereist und hat mit hartnäckiger Recherche Details zur Arbeitspraxis von Facebooks Zensoren erfahren. Diese Ergebnisse hat er nun bei der Heinrich-Böll-Stiftung in Berlin vorgestellt, nächste Woche wird der Vortrag auch bei der re:publica gehalten werden.

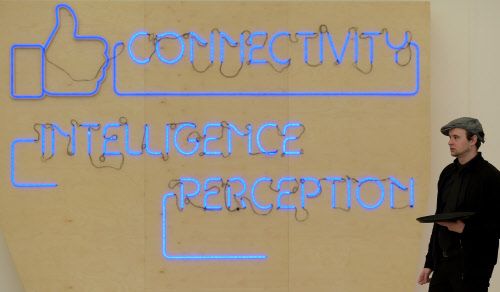

Algorithmen nicht klug genug

Viele Nutzer glauben, dass hauptsächlich Algorithmen die unerlaubten Fotos, Texte und Videos aussortierten. Das entspricht jedoch nicht der Realität. Die künstliche Intelligenz ist in diesem Bereich noch nicht weit genug fortgeschritten, um menschliche Arbeit zu ersetzen. Man denke nur an jenen Fall bei Google-Photos, bei dem ein afroamerikanisches Paar als "Gorillas" markiert wurde. Wie soll diese Software entscheiden, ob beispielsweise Nacktheit einen Fall von Pornografie oder von Kunst darstellt?

Digitale Sweatshops

Das müssen junge, oft weibliche Arbeiter in Ostasien übernehmen. Diese "digitale Müllabfuhr" ist quasi das Äquivalent der Softwarefirmen zur Ausbeutung bei Foxconn und Rohstofferzeugern für die Smartphone- und Computerproduktion. Ein "digitaler Sweatshop" mit menschenunwürdigen Arbeitsbedingungen. Durchschnittlich dreitausend Bilder muss beispielsweise ein Mitarbeiter der Firma "Task us" sortieren, der anonym mit Riesewieck gesprochen hat. Jedes zehnte davon muss gelöscht werden. Am schlimmsten empfand er die Enthauptungen der Terrormilizen wie IS, die seit einigen Jahren auf seinem Bildschirm landen.

Diese Mitarbeiter erkranken nach einigen Monaten oftmals an Paranoia, Depressionen oder Impotenz. Die Auswirkungen auf die psychische Gesundheit seien verheerend, da auch keine Supervision zur Verfügung gestellt wird. Deshalb hat sich das Geschäftsmodell eingebürgert, diese Arbeiter nach spätestens zwei Jahren wieder zu entlassen, um etwaigen Zusammenbrüchen vorzubeugen.

Beweise löschen

Aber ganz abgesehen vom Schicksal der Content-Moderatoren, wirft die Auslagerung gen Fernost auch andere Fragen auf. So ist unklar, wie die Kommunikation zwischen Polizeibehörden im abgebildeten Ort und etwa den Philippinen funktionieren kann. Löschten die Zensoren nicht wichtige Beweise, wenn sie etwa kinderpornografische Abbildungen im digitalen Nirwana verschwinden lassen?

Die Medienforscherin Sarah T. Roberts, die ebenfalls bei der Heinrich-Böll-Stiftung referierte, weist etwa darauf hin, dass die Entscheidungen der Content-Moderatoren natürlich auch eine politische Ebene hätten. Während Enthauptungen der Terrorgruppierungen in Nahost anfangs nicht gelöscht wurden, entfernte Facebook Enthauptungen im mexikanischen Drogenkrieg sofort. Wurde diese Praxis eingesetzt, um außenpolitischen Interessen der USA zu dienen? Diese Fragen bleiben unbeantwortet, da Facebook, Youtube und Twitter ihre detaillierten Leitfäden zur Inhaltslöschung geheim halten.

"Zertrümmerte Köpfe: Okay"

2012 war laut Riesewieck einmal eine jener Anleitungen ins Netz gelangt, die Content-Moderatoren von Vorgesetzten erhalten. Dort stand, dass beispielsweise "zertrümmerte Köpfe okay sind, solange kein Gehirn zu sehen ist". Fotos stillender Mütter mussten gelöscht werden, Landkarten mit eingezeichnetem Kurdistan auch. Außerdem soll vor jeder Löschung beachtet werden, ob Ironie im Spiel ist – oder ob jemand mit prinzipiell harmlosen Bildern gemobbt wird. Das soll binnen weniger Sekunden passieren. Und wäre, so Riesewieck, wahrscheinlich zu komplex, um in dieser Zeit von universitär ausgebildeten Psychologen entschieden zu werden. (fsc, 29.4.2016)